データ分析基盤を導入したいが何から始めればよいかわからない。

データ分析基盤導入に関わる人材がおらず困っている。

導入を考える上でのヒントとなるような事例が知りたい。

そのような方に、本記事ではデータ分析基盤を導入する方法や導入事例を解説いたします。

- データ分析基盤とは

- データ分析基盤導入のメリット

- データ分析基盤導入のポイント

- データ分析基盤導入事例

データ分析基盤導入でお悩みの方は、ぜひ本記事を課題解決にお役立てください。

この記事の目次

データ分析基盤を導入するには?

スマートフォンやIoTデバイスの普及に伴い、データ流通量が飛躍的に増大する昨今。企業運営においてもデータ活用が重要な要素となる中で、「データ分析基盤」の導入が注目されています。

しかし、その具体的な内容や導入するメリット、そして導入手順についてはイメージできないという方も多いのではないでしょうか。

データ分析基盤とは何か、導入のメリットについて解説していきます。

データ分析基盤とは?

データ分析基盤とは、膨大なデータを効果的に分析、管理するなどの役割を持つシステムの集合体のことです。

各種データベースやIoTデバイスなどの情報源から大量の形式の異なる生データ(元のままの未加工のデータ)を収集し、整理、保管し、必要に応じて効率的なレポーティングによる分析まで、一気通貫で対応できる仕組みです。蓄積されたデータは生成AIなどで活用される機械学習にも必要です。

導入プロセスとして、まずは組織のニーズに合わせたデータ基盤のツールの選定が重要です。

その後、必要なデータソースを特定し、ETLプロセス(※1)を構築してデータを統合します。統合されたといってもデータは単なる数字や文字の羅列であるため、そのままでは利用できません。そこで、BIツールや統計ツールを用いて集計、チャート、グラフなどの形で誰にでも分かりやすく可視化し、分析を行えるようにします。

※1 ETLプロセスとはデータ統合のための手順です。この手順には、データの抽出(Extract)、変換(Transform)、および読み込み(Load)の3つのステップが含まれます。これらのステップを経ることで、さまざまなソースからデータを取り出し、必要な形式に変換して、最終的に一元化しデータストレージに統合します。このプロセスにより、データが分析やレポーティングに適した状態で利用可能になります。

【データ分析基盤の構成要素】

- 収集

- 加工

- 蓄積

- 分析・可視化

「蓄積」では、データを以下の3つの層に格納します。

- データレイク:生データを格納。「湖」のようにデータを貯めておく場所。

- データウェアハウス(DWH):分析目的のため集められたデータの統合された格納場所。基本的に時系列で格納される。

- データマート:特定のニーズごとに分類されたデータ

データ分析基盤導入のメリット

データ分析基盤を導入することで、以下のようなメリットが得られます。

- 意思決定の高速化

- 運用の効率化

- 全社的なデータ利活用

メリット1. 意思決定の高速化

データ分析基盤は高速なデータ処理を可能にし、取り出したデータはBIツールや分析プラットフォームに連携されて、データを可視化できるようになります。その結果、データドリブン(Data Driven:データに基づく判断・行動)による迅速な意思決定が可能になります。

メリット2. 運用の効率化

表記揺れの訂正のような、人が時間をかけて行っていた作業も自動化できます。 ETLプロセスを自動化し、データの収集から加工、分析までの流れを一元管理することで、手作業によるエラーや時間の浪費を削減します。

メリット3. 全社的なデータ利活用

データ格納場所を統一すると、企業内のさまざまな部門やチームが一貫したデータにアクセスできるようになります。データ抽出やレポーティング担当者による属人化を防ぎ、全社的なデータの利活用が可能となります。

データ分析基盤の導入は、時に複雑で専門知識を要するプロジェクトとなることがありますが、その価値は計り知れないものがあります。効率的なデータ運用と精度の高い分析によって、企業は市場での競争優位を確立しやすくなります。

導入するってどういうこと?

データ分析基盤を導入するとは、組織や企業がデータを効果的に収集、加工、蓄積、分析するためのシステムやツールのセットアップを指します。データウェアハウス、データレイク、データマートなどの構築が、生データから有益な洞察を抽出するための基盤となります。

すべてを一貫してできるツールはあるのか?

市場には多様なデータ分析ツールが存在しますが、すべてのニーズを満たす万能ツールは存在しません。データの種類、量、分析の目的によって適切なツールを選択し、時には複数のツールを組み合わせて使用する必要があります。

例えば、AWS(Amazon Web Services)やGoogle Cloudといったクラウドでさまざまなツールが提供されますし、Tableau、QuicksightなどのBIツールといったソリューションを組み合わせて利用します。

設計、構築する必要がある

どのデータをどのように収集するか、データフローをどうするか、どのプラットフォームで分析を行うか、拡張性を持たせるかどうかなどの要件定義は、組織や事業規模に合わせて決める必要があります。データ分析基盤は部門を横断して活用すべきものであることから、複数の部門の人員が導入に関わるようにすると良いでしょう。

データの集約、クレンジング、そして統合を行うETLプロセスの構築の段階では、データセキュリティやプライバシー保護の措置も取り入れる必要があります。

専門家のサポートを受ける

データ分析基盤の設計および実装には高度な専門知識が必要とされるため、専門家の支援を受けることが推奨されます。

データエンジニアやシステムアーキテクト、ビジネスアナリストなど、異なるスキルを持つプロフェッショナルをメンバーに含むチームを作り、効果的なデータ分析環境の設計と構築を進めます。

また、プロジェクトの進行に合わせて、教育セミナーやワークショップを通じて社内の人材を育成することも大切です。

データ分析基盤は導入したら終わりではありません。データを最大限に活用し、経営の質を高めるために、継続的な改善とアップデートが求められます。開発と運用どちらもできる人材が自社にいれば、開発と運用の改善サイクルを迅速に進めることができます。

導入事例

データ分析基盤の導入例を5件ご紹介します。

デジタル庁 「sukuna」

画像出典:https://digital-gov.note.jp/n/na227ce427930

従来、省庁のデータ分析やレポート作成は民間企業などへ委託されていましたが、委託契約や依頼、レポート内容の精査など、各工程で多くの時間が取られていました。そこで迅速に政府内でデータ蓄積、分析まで行うために導入されたのが「sukuna」です。「sukuna」はガバメントクラウドのGCP(Google Cloud Platform)上に構築されており、GCPが提供している様々なマネージドサービスを活用できます。

省庁ごとに管理され、散在していたデータを収集・蓄積することで、必要な時に必要なデータを即座に参照することができるようになります。大規模かつ複雑なプロジェクトがスムーズに管理できるようになると期待されています。

九州旅客鉄道株式会社「InfoFrame Dr.Sum EAMotionBoard導入」

画像出典:https://jpn.nec.com/infoframe/drsum/case/jr-kyushu/index.html

旧来型業務システムのデータ抽出後、Excelで管理していましたが、その作業に時間がかかっていました。

時間的コストの削減と、BIツールにより情報を可視化して共有することを目的としてNECの「InfoFrame Dr.Sum EAMotionBoard」を導入。その結果、データ分析の高速化、報告書の作成時間短縮に成功しています。

さらに、BIツール機能活用を促すための社内勉強会を開催、本社と現場の情報共有にもツールの機能を有効活用することで、本社では年間約192時間、各保守区では年間約1,152時間もの削減効果を出しています。

株式会社良品計画 「AWS導入」

画像出典:https://aws.amazon.com/jp/solutions/case-studies/ryohin-keikaku/

グローバルな展開を続けている株式会社良品計画では、変化のスピードに対応するためにデータ分析基盤の導入を進めました。オンプレミスのDHWを構築と比較して低コストで導入できること、構築までの時間も短いことからAWSを採用。

年間数億件に及ぶ莫大な顧客行動データを分析するためのDHWシステムをAWSクラウドのAmazon RedshAmazon Redshiftift上に構築しました。Amazon Redshift導入後、1か月程度で複数のマーケティング施策を打ち出すなど成果がでています。

株式会社ぐるなび 「BigQueryを中心にGoogle Cloud」

画像出典:https://cloud.google.com/customers/gurunavi/?hl=ja

飲食店情報サイトを運営する株式会社ぐるなびは、オンプレミスでDWHを構築、利用してきました。しかし生データを抽出し、DWHにロードさせるのに時間がかかることが課題となっていました。

そこで、BigQueryを採用し、BigQueryを中心にGoogle Cloud上でデータ分析基盤を構築し、数年をかけてオンプレミスからクラウドへのマイグレーション(移行)を進めました。

ジョブ失敗の時の原因究明が迅速にできるようになった、ETLに関わるランニングコストをおよそ50%も削減できた、など良い効果がでています。

参照:ぐるなび:BigQuery を中心にデータ収集からデータの可視化や活用まで Google Cloud でデータ分析基盤を刷新

ヤマハ発動機株式会社 「Google Cloud、AWS」

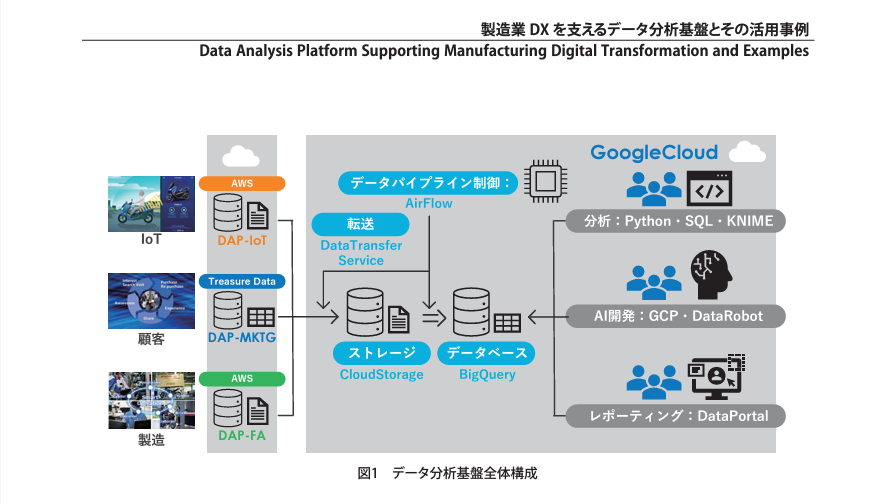

画像出典:https://global.yamaha-motor.com/jp/design_technology/technical/presentation/pdf/browse/57gs07.pdf

データによる新たな顧客体験の創出を目指してDX化を推進しているヤマハ発動機株式会社は、Google Cloud、AWSを活用したデータ分析基盤を構築しました。効率的なデータ活用と製造業のデジタルトランスフォーメーション(DX)が実現。

成功のポイントは、製品IoTデータ、顧客データ、製造データを統合し、AirFlowを使ってデータ転送と加工を自動化したことです。さらに、BigQuery、VertexAI、DataRobotを活用して高度な分析を実施し、Google Data Portalを通じてグローバルに分析結果を共有しています。

データ分析基盤導入のポイント

データ分析基盤の導入を成功させるにはいくつかの重要なポイントを押さえる必要があります。

特に、重要なポイントを3点ご紹介します。

- セキュリティ対策

- コストの把握

- データ活用における人材の確保

1.セキュリティ対策

データ分析基盤を導入する際には、セキュリティが最優先事項です。

データレイクやデータウェアハウスに蓄積されるビッグデータは企業にとって非常に重要な財産であり、そのセキュリティ対策は欠かせません。

セキュリティの観点からは、例えばAWS/Azure/GCPといったクラウドプラットフォームを活用することで、アクセスログのモニタリングなどの高度なセキュリティ機能によりデータを保護することができます。

2.コストの把握

データ分析基盤の導入と運用には相応のコストがかかります。

初期投資だけでなく、継続的なメンテナンス費用やアップグレード費用も考慮する必要があるため、費用対効果の検討も欠かせません。コスト効率の良い方法を選定することにより、長期的な運用コストを抑えることが可能です。データ分析基盤の導入を通じて全社的なデータ統合を進めることにより、データ操作の工数やシステムの維持にかかるコストを削減できる場合もあります。

データ分析基盤を効果的に運用するためには、コスト要素を総合的に評価し、長期的な視点で予算計画を立てることが重要です。

3.データ活用における人材

データ分析基盤を最大限活用するには、データの抽出から分析、ビジュアライゼーションまでを行い、データドリブンな意思決定に繋げられる人材が不可欠です。

データサイエンティストやデータエンジニアはもちろん、ビジネスインテリジェンス(BI)のスキルをもつデータアナリストが必要となるでしょう。

社内でデータ分析領域に関するスキルを持つ人材がいない場合は、外部からの採用を行うか、セミナーや研修を通じて社内の人材を育成する必要があります。

データ分析基盤の導入は、単に技術の導入で終わらせるのではなく、セキュリティ、コスト管理、人材育成といった複数の側面からアプローチすることが成功への鍵となります。

まとめ

データ分析基盤の導入が成功すれば、データ抽出や資料作成の時間的コストが大幅に削減され、データの社内での分断を防ぎ全社で有効活用することが可能となります。

データに関して企業が直面する課題や目的はさまざまであり、何かひとつのツールを導入すれば良いというものではありません。

目的に合わせたデータ分析基盤の設計、構築を行うには専門家のサポートが必要不可欠です。それと同時にデータ分析やシステム運用ができる人材が現状社内にいない場合は、自社人材の育成も行う必要があります。

データ分析基盤をもとにデータを戦略的な資産として活用し、企業の競争力を高めましょう。

この記事を書いた人

西潤史郎(監修)/データ分析基盤.com編集部

uruos.net/Submarine LLC

データエンジニア/Editor Team

ここに紹介文が入ります

担当可能なサービス